À l’occasion de la journée mondiale de la société des télécommunications et de l’information, le National Computer Board a organisé un atelier de travail centré sur le Big Data, organisé sous l’égide du ministère des TIC mauricien. Une cinquantaine de personnes travaillant dans le domaine de l’IT avait fait le déplacement pour se familiariser avec le Big Data et élargir leur réseau professionnel.

En plus du ministre des TIC, M. Yogida Sawminden, quatre orateurs majeurs étaient présents ce jour là, il s’agissait de :

- Andrew Quixley, sales lead de Watson, la plate-forme Artificial Intelligence (AI) d’IBM Moyen-Orient et Afrique.

- Amrit Nawoor, Cloud Technology Manager pour Oracle (pays SADC).

- Amit Juggurnath, Consultant Technologique Senior de Presales couvrant la région de l’Est et SADC.

- Ajmal Dookhan, directeur et project manager de logiciels chez Business Objectifs.

Big Data, ou volumes massifs de données

Avec l’explosion du nombre de terminaux mobiles et des services digitaux, les volumes de données stockées par les systèmes d’information s’accroissent de manière exponentielle. Chaque jour, nous générons pas moins de 2,5 trillions d’octets de données. À tel point que 90 % des données dans le monde ont été créées au cours des deux dernières années seulement. Cela crée alors des bases de données géantes qu’il n’est plus possible de stocker par l’informatique traditionnel. C’est là que le big data (ou méga données en français) est apparu, il s’agit de nouvelles infrastructures destinées à gérer ces immenses volumes de données.

« L’information est le carburant du 21e siècle et l’analyse est le moteur à combustion » Peter Sondergaard, vice-président senior Gartner

Ces données proviennent de partout : de capteurs utilisés pour collecter les informations climatiques, de messages sur les sites de médias sociaux, d’images numériques et de vidéos publiées en ligne, d’enregistrements transactionnels d’achats en ligne ou encore de signaux GPS de téléphones mobiles.

4 caractéristiques clés pour être qualifiée de plateforme Big Data

@IBM

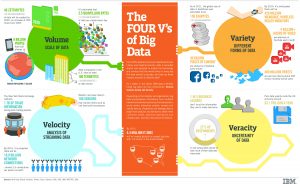

Le Big Data couvre quatre dimensions (règle des 4V) : Volume, Variété, Vélocité et Véracité.

- Volume : le nombre de données à traiter doit être important. Ces données peuvent se compter en téraoctet, voire en pétaoctets.

- Variété : le Big Data se présente à travers une variété de sources et sous la forme de données structurées ou non structurées.

- Vélocité : un certain niveau de vélocité et de réactivité doivent être atteints en terme de traitement des données. Il y a de nombreux processus chrono-sensibles demandant un traitement de l’information quasiment instantané.

« 53 % des exécutants disent que les informations critiques sont délivrées trop tard » a déclaré Amrit Nawoor, Cloud Technology Manager pour Oracle.

- Véracité : il est important d’avoir des données fiables. Il s’agit d’un défi majeur du Big Data, d’autant plus difficile à relever quand la variété et le nombre de sources des données augmentent.

Une demande croissante pour le Big Data

Confronté très tôt à ces problèmes de masses de données, les géants du web tels Yahoo, Google et Facebook ont été pionés dans le domaine. Toutefois, depuis quelques années déjà, le Big Data commence à être utilisé dans d’autres domaines :

- Les banques l’utilisent pour repérer des fraudes en temps réel,

- Les telecoms pour mieux exploiter les données de leurs clients,

- Le domaine de l’industrie s’en sert pour la maintenance prédictive des équipements,

- Dans le secteur de la santé : pour l’aide au diagnostic médical,

- Dans les transports pour optimiser les flux de marchandises, etc.

Dorénavant, à l’aide d’outils analytiques et de la modélisation de données, les entreprises et administrations peuvent faire de l’analyse tendancielle ou prédictive, dresser des profils, anticiper des risques et suivre des phénomènes en temps réel. Les entreprises commercialisant des solutions Big Data profitent d’un marché florissant, estimé à plusieurs dizaines de milliards de dollars.

Et pourtant, malgré la demande croissante pour l’analytique Big Data, les speakers de l’atelier ont tous déploré la pénurie de data scientists dans le secteur. Il s’agit selon eux, du défi majeur que présente le Big Data dans notre région.

Applications possibles du Big Data dans la région

Andrew Quixley a conclu sa présentation en évoquant avec l’audience des possibilités d’application pour le Big Data. En sont ressorti :

- Des chatbox pour le customer service afin de fournir une réponse 24/7. Cela permettrait notamment l’automatisation dans les banques.

- Le diagnostique du diabète. La population mauricienne est particulièrement affectée par cette maladie, aujourd’hui, il est désormais possible de détecter la présence ou non de la maladie via une image de la rétine du patient.

- Une solution efficace pour préserver la barrière de corail et la faune marine. La pêche illégale touche de plein fouet la petite île, c’est un défi économique et environnemental majeur pour le pays. Le big data pourrait bien être la solution. À l’aide des données, les autorités peuvent surveiller l’activité de pêche sur les côtes. Ainsi, ils sont avertis en temps réel du nombre de bateaux, de leur localisation et de leur provenance.

Andrew Quixley

L’atelier s’est conclut sur une prise en main rapide de la plateforme Bluemix par tous les participants. Ces derniers ont été invités à créer un chatbot prenant des réservations pour un restaurant.

L’île Maurice a beaucoup à bénéficier du Big Data. Le pays pourrait se placer comme un pool de talents, ce qui diminuerait la fuite des cerveaux et augmenterait le nombre d’investissements du secteur privé. Cependant, pour y arriver le gouvernement a un rôle critique à jouer et doit investir considérablement dans des formations scientifiques.